洞察大數據本質 開啟高效學習與軟件開發之門

在當今數字化的浪潮中,大數據已不再是遙不可及的概念,而是驅動各行各業創新的核心引擎。對于有志于投身大數據領域的開發者而言,一個根本性的認知至關重要:唯有真正了解大數據,才能更好地學習大數據,并最終精通大數據軟件開發。 這并非一句空話,而是一條貫穿學習與實踐的清晰路徑。

一、 了解大數據:超越技術表象,理解核心范式

學習大數據,首先必須超越對Hadoop、Spark、Flink等具體工具或框架的孤立認知。真正的“了解”,意味著深入其內核,把握其賴以存在的根本邏輯。

- 理解“大”的本質: 大數據的“大”,不僅指體積(Volume),更關鍵的是其多樣性(Variety)、高速性(Velocity)和價值密度低(Value)等特征。了解這些特征,才能明白為何傳統數據處理技術失效,以及分布式計算、列式存儲、流處理等新技術為何成為必然。例如,認識到數據流的“高速性”,自然會導向對Kafka、Flink等流處理框架的學習需求。

- 把握核心思想: 大數據處理的核心理念是“分而治之”(Divide and Conquer)和“移動計算而非數據”。了解MapReduce編程模型、分布式文件系統(如HDFS)的設計哲學,比單純記憶API更有助于構建扎實的知識體系。這決定了你在設計系統時,能否做出正確的架構抉擇。

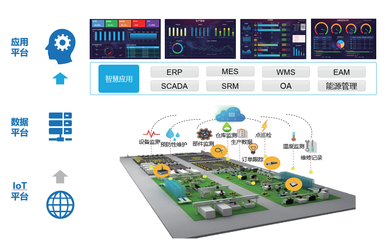

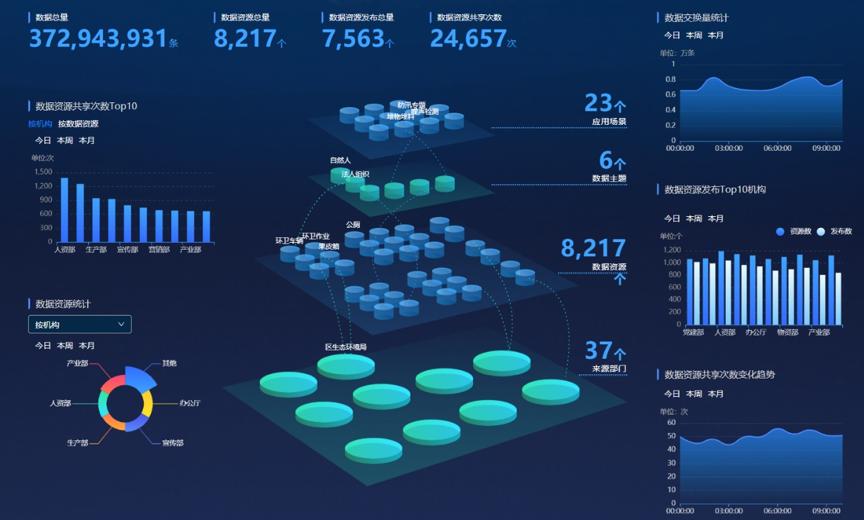

- 明晰生態系統: 大數據是一個龐大的生態系統,包含數據采集、存儲、計算、分析和可視化等多個層面。了解各層主流技術(如Logstash采集、HBase存儲、Spark計算、Tableau可視化)及其間的協作關系,能幫助你在學習中建立全景視圖,避免陷入“只見樹木,不見森林”的困境。

二、 基于理解的學習:從原理到實踐的高效路徑

當你對大數據的內涵與范式有了清晰認知后,學習過程將事半功倍,目標更為明確。

- 原理驅動,而非工具驅動: 優先學習分布式系統原理、數據倉庫建模理論、CAP定理等基礎知識。理解了數據一致性、可用性、分區容忍性的權衡,就能更好地理解為何HBase和Cassandra會有不同的設計選擇。這為后續學習具體工具提供了堅實的理論框架。

- 按需深入技術棧: 根據你對大數據應用場景(如實時推薦、風控分析、用戶畫像)的理解,有選擇地深入學習相應的技術棧。例如,側重離線批處理,可深入Hive、Spark SQL;側重實時計算,則需鉆研Storm/Flink和狀態管理。這種目標明確的學習,效率遠高于漫無目的地收集技術名詞。

- 建立關聯知識網絡: 將新學習的每項技術與你已經理解的核心概念關聯起來。學習Spark時,思考它如何優化了MapReduce的中間結果落地問題;學習Kafka時,理解它作為分布式提交日志如何保障消息順序和持久化。這種關聯記憶使知識網絡更加牢固。

三、 指導軟件開發:構建健壯、可擴展的大數據應用

所有的了解與學習,都要服務于開發出高質量的大數據軟件。深刻的理解在此轉化為卓越的工程能力。

- 架構設計能力: 了解數據規模、增長速度和業務需求(如實時性要求),是進行技術選型和架構設計的前提。你是否需要Lambda架構還是Kappa架構?數據湖還是數據倉庫?這些重大決策都根植于你對大數據本身和業務場景的深刻理解。

- 性能優化意識: 理解數據傾斜、Shuffle過程的網絡與磁盤IO開銷、序列化效率等底層原理,能幫助你在開發中主動避免性能瓶頸,編寫出更高效的代碼。例如,知道Spark中寬依賴與窄依賴的區別,就會在設計算法時盡量避免不必要的Shuffle。

- 問題排查與調優能力: 當應用出現運行緩慢或錯誤時,基于原理的理解能讓你快速定位問題根源——是資源不足、數據傾斜,還是代碼邏輯缺陷?你能夠解讀復雜的日志和監控指標(如GC情況、Executor負載),并進行有效的參數調優(如Spark的并行度、內存分配)。

- 把握技術演進趨勢: 了解大數據從批處理到流批一體,再到云原生、湖倉一體等發展趨勢,能讓你在技術選型上更具前瞻性,使開發的系統更具生命力和適應性。

###

“了解大數據”是地圖與指南針,“學習大數據”是行走與攀登的過程,而“大數據軟件開發”則是建造屬于自己山峰的實踐。跳過對本質的探尋而直接追逐技術細節,猶如在迷霧中盲目前行,事倍功半。因此,請投入時間先理解“為什么”,再探究“怎么做”。當你真正洞悉了數據的流動、計算的分工與結果的匯聚這一宏大敘事,你不僅將成為一名熟練的大數據開發者,更有可能成長為駕馭數據洪流、解決復雜問題的架構師與創新者。從理解開始,讓學習有的放矢,讓開發游刃有余。

如若轉載,請注明出處:http://m.bracq.cn/product/42.html

更新時間:2026-01-07 00:28:10